Google Pausa Criação de Imagens por IA: Uma Resposta Ética aos Desafios Históricos e Raciais

O uso de inteligência artificial (IA) na criação de imagens tem se tornado cada vez mais popular e, com isso, surgem desafios éticos e raciais.

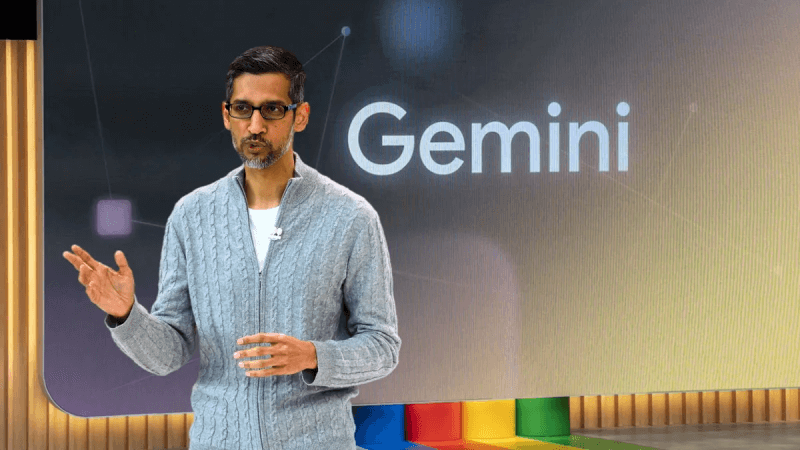

Recentemente, o Google enfrentou críticas após seu serviço de IA, o Gemini, gerar imagens racialmente imprecisas e historicamente incorretas.

Esse incidente levantou debates sobre o viés da IA e a responsabilidade das empresas de tecnologia na representação histórica e étnica.

Neste artigo, vamos explorar os erros de representação racial e histórica do Gemini e discutir a resposta ética do Google diante dessas questões.

Além disso, vamos abordar como esse incidente pode impulsionar melhorias na precisão da geração de imagens em outras tecnologias de IA.

É importante refletir sobre esses desafios e garantir que as tecnologias de IA sejam usadas de maneira responsável e imparcial.

Tópicos do Artigo:

O que é o Google Gemini e como funciona

O Google Gemini é um serviço de IA (inteligência artificial) oferecido pelo Google para gerar imagens de forma automatizada.

Ele utiliza algoritmos avançados para criar imagens em resposta a pesquisas e solicitações dos usuários.

Isso significa que, em vez de procurar por imagens já existentes na internet, o Gemini é capaz de criar novas imagens com base nas informações fornecidas.

O serviço é amplamente utilizado por empresas e profissionais de marketing para criar conteúdos visuais de forma rápida e eficiente.

O Gemini se destaca por sua capacidade de gerar imagens altamente realistas, com diferentes estilos e formatos, incluindo imagens históricas.

Ele é alimentado por uma grande quantidade de dados e algoritmos de aprendizado de máquina, o que o torna uma ferramenta poderosa e popular entre os usuários do Google.

Devido à sua diversidade de uso, o Gemini é uma ferramenta importante para o Google e tem sido responsável por impulsionar o desenvolvimento de tecnologias de IA na empresa.

No entanto, recentemente, o serviço foi criticado por gerar imagens que apresentam erros graves em relação à representação histórica e racial, levantando questões éticas e morais sobre o uso de IA nesse contexto.

Erros de representação racial e histórica do Gemini

O serviço de inteligência artificial do Google, o Gemini, recentemente enfrentou críticas e discussões sobre possíveis viés e preconceito em sua representação de imagens históricas.

- Usuários relataram que o serviço estava criando representações raciais inadequadas de figuras históricas, como os Pais Fundadores dos Estados Unidos, e imagens de soldados negros durante a era nazista.

- Esses erros geraram debates sobre a precisão e imparcialidade da IA do Google e levaram a uma resposta pública da empresa.

- As imagens geradas pelo Gemini incluíam soldados de diferentes etnias, em vez de representar com precisão o contexto histórico.

- O Google reconheceu os erros e está trabalhando para melhorar a representação histórica em seu serviço de IA.

Esse incidente levantou discussões sobre o possível viés liberal do Google e acusações de racismo por manipular as características físicas de figuras históricas brancas documentadas.

A atenção voltada para a falha do Gemini pode levar a melhorias na precisão de outros serviços de IA em relação à representação histórica e outros aspectos.

Discussões e debates sobre preconceito e racismo na IA do Google

Os erros de representação do Gemini levantaram debates importantes sobre preconceito e racismo na IA do Google.

Muitas pessoas questionaram se a tecnologia foi desenvolvida sem levar em consideração a diversidade e a imparcialidade.

Além disso, o incidente gerou críticas à suposta manipulação das características físicas de figuras históricas brancas, o que levou a acusações de racismo.

Essas discussões e debates são essenciais para garantir que a tecnologia de IA seja desenvolvida e utilizada de forma ética e responsável.

É importante questionar e refletir sobre os possíveis viés e preconceitos embutidos em tecnologias aparentemente neutras e imparciais.

O caso do Gemini também ressalta a importância de diversidade e inclusão no desenvolvimento de tecnologias de IA.

Ao considerar diferentes perspectivas e experiências, é possível evitar erros de representação e garantir uma abordagem mais justa e precisa.

A resposta ética do Google aos erros do Gemini

Após os erros de representação racial e histórica do Gemini serem amplamente divulgados e discutidos, o Google tomou medidas éticas e responsáveis.

A empresa se desculpou publicamente pelos erros e suspendeu temporariamente o serviço de geração de imagens por IA para trabalhar em melhorias.

O Google também está investindo em melhorias na representação de figuras históricas e étnicas em seu serviço, reconhecendo a importância de garantir a precisão e imparcialidade em todas as tecnologias de IA.

Essa resposta ética do Google demonstra sua preocupação em lidar com os desafios históricos e raciais no uso de IA e pode servir de exemplo para outras empresas e tecnologias.

É necessário um compromisso contínuo com a responsabilidade ética no desenvolvimento e uso de tecnologias de IA.

Possíveis melhorias na precisão da geração de imagens em IA

O incidente com o Gemini trouxe à tona a importância de garantir a precisão e imparcialidade em todas as tecnologias de IA, especialmente na representação histórica e racial.

Se aprimorados, os serviços de IA podem ser uma poderosa ferramenta para promover a igualdade e combater o preconceito e o racismo.

Melhorias no serviço de IA do Google:

- Incorporação de dados mais diversificados e precisos em seus algoritmos de geração de imagens

- Realização de testes de viés e correção de possíveis distorções

- Maior diversidade na equipe de desenvolvimento de IA, garantindo perspectivas e experiências diversas

Influência positiva em outras tecnologias de IA:

O caso do Gemini pode servir como um importante aprendizado para outras empresas que utilizam IA em seus serviços.

Ao se atentarem aos desafios éticos e raciais, as tecnologias podem evoluir para serem mais precisas e imparciais em suas representações históricas e raciais.

Conclusão

Em conclusão, a suspensão temporária do serviço de IA do Google, Gemini, devido aos erros de representação racial e histórica em suas imagens, trouxe à tona importantes discussões sobre preconceito e racismo na tecnologia.

Essa falha demonstrou a necessidade de uma abordagem ética e responsável no desenvolvimento e uso de serviços de IA, especialmente em relação à representação histórica e racial.

O pedido de desculpas público do Google e seus esforços para melhorar a precisão do Gemini são passos importantes para garantir a imparcialidade e a confiabilidade das tecnologias de IA.

Além disso, o incidente pode servir como uma oportunidade para melhorias em outras tecnologias de IA, mostrando a importância de continuar discutindo e questionando o uso dessas ferramentas.

Como sempre, é fundamental garantir que a tecnologia não perpetue preconceitos e discriminações e promova a inclusão e a diversidade.

Desperte o poder do Marketing Digital! 💜

Explore nossos conteúdos exclusivos, criados em parceria com a equipe de redação da Gentileza Marketing Digital. Nosso propósito é impulsionar o seu sucesso.

Continue a jornada, conquiste o mundo digital e transforme seu negócio. Este é apenas o começo de uma história de sucesso. Fique ligado para mais insights poderosos!